GPT-1 논문에 대한 리뷰를 진행해보려고 한다.

레이블링된 텍스트 데이터가 제한적인 상황에서 자연어 이해와 학습된 model이 task를 적절히 수행하는데 어려움이 있었는데, generative pre-traning과 fine-tuning을 통해 레이블되지 않은 corpus를 사용한 task에서 큰 성과를 얻었다고 한다.

본 논문은 Transformer, Attention 및 자연어 처리 부분에 대한 기초지식이 있다는 가정 하에 설명하도록 하겠다.

paper link

https://cdn.openai.com/research-covers/language-unsupervised/language_understanding_paper.pdf

1. Introduction

raw text에서 효과적으로 학습하는 능력은 NLP에서 supervised learning(지도학습)에 대한 의존도를 완화하는데 중요하다. 대부분의 deep learning에서는 레이블링된 데이터가 필요하며, 주석 리소스가 부족한 도메인에서 적용을 제한한다.

레이블이 없는 데이터로부터 언어 정보를 활용할 수 있는 model은 더 많은 주석을 수집하는 것에 대한 대안을 제공하지만, 이는 시간 소모와 cost 증가의 우려가 있다.

supervised learning이 가능한 경우에도 unsupervised learning으로 학습하는 것이 성능을 향상시킬 수 있다. 그 근거로, NLP task 성능을 개선하기 위해 pre-trained된 word embeddings의 광범위한 사용이 있다.

그러나 레이블링되지 않은 텍스트에서 단어 수준 이상의 정보를 활용하는 것에 대해 두가지를 고려해봐야 한다.

- transfer(전이)를 위해 유용한 텍스트 표현을 학습하는데 가장 효과적인 최적화 목표의 type이 불분명하다.

- 이러한 학습된 표현을 target task로 전이하는데 가장 효과적인 방법에 대한 기준이 없다.

이러한 불확실성이 언어 처리를 위한 효과적인 semi-supervised learning을 개발하는 데 어려움을 초래했다.

본 논문에서는 unsupervised pre-training과 supervised fine-tuning의 조합을 사용하여 semi-supervised 접근 방식을 탐구한다.

목표는 적은 적응으로 다양한 task에 transfer할 수 있는 보편적인 표현을 배우는 것이다.

GPT-1 model 구조로는 Transfomer를 사용하고, 1) 자연어 추론 2) 질문 응답 3) 의미 유사성 4)텍스트 분류 의 4가지 언어 이해 task에 대해 접근 방식을 평가한다.

각각의 task를 위해 설계된 구조를 사용하는 trained model보다 성능이 우수하며, 12개 task중 9개에서 SOTA를 넘어섰다.

2. Related Work

Semi-supervised learning for NLP - NLP를 위한 반지도학습

본 논문의 연구는 Semi-supervised learning for NLP의 범주에 속한다. 초기 접근 방식은 레이블이 없는 데이터를 사용하여단어, 구절 수준의 통계를 계산 후 이를 supervised model의 특징으로 사용했다. 지난 몇년동안 연구자들은 레이블이 없는 corpus에서 training된 word embedding을 사용하여 다양한 task에서 성능을 향상시켰다.

이러한 접근 방식은 주로 단어 수준 정보를 transfer하는 반면, 본 논문에서는 더 높은 수준의 의미를 포착하는 것을 목표로 한다.

즉, 레이블이 없는 데이터에서 단어 수준 이상의 의미를 학습하고 활용하는 것에 대한 연구를 진행했다.

Unsupervised pre-training - 비지도 사전학습

초기 연구들은 이 기술을 이미지 분류 및 회귀 작업에 사용하는 것을 탐구했다. 이후 연구는 pre-traning이 정규화 방식으로 작용하여 Deep Neural Networks에서 더 나은 일반화를 가능하게 한다는 것을 입증하였다.

최근 task에서는 이 방법이 이미지 분류, 음성 인식, 개체 불일치 해소, 기계 번역과 같은 다양한 task에서 DNN을 training하는 데 사용하고 있다.

본 연구와 가장 관련된 연구는 language modeling objective를 이용하여 pre-training 후 supervision을 통해 특정 task에 대해 fine-tuning하는 방법이다.(Dai et al. 및 Howard, Ruder)

그러나 pre-training phase가 일부 언어 정보를 찾아내는데 도움을 주긴 하지만, LSTM model은 예측 능력을 짧은 범위로 제한한다.

반면 본 연구의 transformer network는 실험에서 입증된 바와 같이 더 긴 범위의 언어 구조를 찾아낼 수 있다. 또한 transfer 과정에서 model architecture를 최소한으로 변경하는 매개변수를 필요로 한다.

Auxiliary training objectives - 보조 훈련 목표

Auxiliary unsupervised training 목표를 추가하는 것은 semi-supervised learning의 선택가능한 형태 중 하나이다.

- Collobert, Weston의 초기 작업에서는 품사 tagging, chunking, 이름붙은 개체 인식, 언어 모델링과 같은 다양한 보조 NLP task를 사용하여 semantic(의미적) role labeling을 개선하였다.

- 최근에는 Rei가 target task 목표에 auxiliary language modeling 목표를 추가하여 sequence labeling task에서 성능 향상을 입증하였다.

본 논문의 실험에서도 auxiliary objective를 사용해 보았지만, unsupervised pre-training은 이미 target task와 관련된 여러 언어적 측면을 학습했음을 보였다.

3. Framework

본 연구의 훈련 절차는 2단계로 구성된다. i) 대량의 corpus에서 high-capacity language model을 학습하는 것 ii) 이후 레이블이 있는 데이터를 사용하여 model을 조정한다.

우선, GPT-1의 Architecture는 다음과 같다. Transformer의 Decoder만을 사용한다.

Transformer 구조에서 변형하여 Decoder 단독으로 구성되어 있기 때문에, Cross Attention layer도 제거되었다. Decoder만을 사용하는 이유는

- GPT-1은 다음 언어를 예측하는 방법을 사용하여 학습하기에 Decoder가 수행하기 적합한 문제

- Model Architecture를 더 간결하게, 연산량을 더 적게

하기 위함이다.

1. Unsupervised pre-training

unsupervised corpus token 집합 U(input token)의 손실함수 L1 Loss의 수식은 다음과 같다.

k는 window size, 조건부 확률 P는 parameter Θ를 가진 신경망을 사용하여 modeling된다. parameter는 SGD(확률적 경사 하강법)을 사용하여 training을 진행한다.

language model로는 앞서 설명했던 대로 multi-layer Transformer decoder를 사용하는데, Transformer의 변형이다.

input context token에 대해 Multi-head Self-Attention 연산을 적용 후 target tokens에 대한 출력 분포를 생성하기 위해 position-wise feedforward layers를 따른다.

2. Supervised fine-tuning

model을 식 (1)의 목적에 맞게 traning 후 parameter를 supervised target task에 맞게 조정한다.

레이블이 있는 dataset C를 가정하고, 각 instance는 input tokens의 sequence(x1,...,xm)과 label(y)로 구성된다.

input은 pre-trained modeld을 통해 전달되어 최종 transformer block의 활성화 h를 얻은 후 linear output layerd의 parameter W에 전달되어 각 task마다 label y를 예측한다.

Supervised Loss L2는 앞서 pre-training과 달리 Supervised learning이기 때문에 fine-tuning을 위한 dataset은 레이블링이 되어 있다. 다음의 objective가 최대가 되도록 학습한다.

본 논문에서 language modeling을 auxiliary objective(보조 목표)로 포함시키는 것이 학습을 도왔다( i. supervised model의 generalization 향상 ii. model의 수렴 가속)는 것을 추가로 발견했다. next objective(가중치 λ)를 최적화한다.

- Layer Norm: 각 layer의 output을 normalization하여 안정성을 높인다.

- Feed Forward: input을 non-linear function으로 변환하여 representation을 강화한다.

- Masked Multi Self Attention: 다른 token과의 상관관계를 학습하여 context information을 반영한다.

Task-specific input transformations

앞서 언급한 것처럼 GPT-1은 최소한의 변화로 여러 task를 다룬다. 기존 연구들은 transferred representation 위에 새로운 architecture를 달아 복잡한 구조였다. 많은 양의 task-specific customization이 필요하여 transfer training을 사용하지 않았다.

반면 GPT-1은 각 task에 해당하는 구조화된 input의 변형을 통해 transfer training을 최소한의 변환으로로 가능하게 하였다.

모든 변환에는 무작위로 초기화된 <start>, <extract> token을 추가하는 것이 포함되어 있다.

- Classification: 기존 분류 문제와 같다.

- Textual entailment: 연결된 premise(전체) p와 hypothesis(가정) h 두가지 sequence token 사이에 구분 문자($)를 추가한다.

- Similarity: 두 문장의 유사성을 비교할 때는 문장간의 순서가 존재하지 않다. 이를 반영하기 위해 input sequence를 수정하여 문장 순서의 경우의 수(문장 a,b 또는 b,a 순서 2가지)를 포함하여 구분자($)를 추가한다.

각각의 문장 순서를 독립적으로 처리 후 linear layer 전에 element-wise로 합하여 출력한다. - Question Answering and Comonsense Reasoning: 이 task에서는 지문 z, 질문 q, 정답 리스트(a1,...,ak)가 있다.

각 정답 리스트 k개만큼의 모델에 각각 forward하여 리스트들의 softmax를 통해 noramalization 후 가장 정답에 가까운 값을 구한다. 구분자 token [z;q;$;ak]를 추가한다.

4. Experiments

unsupervised pre-training

- BooksCorpus dataset - 7,000개가 넘는 다양한 장르의 출간되지 않은 책들로 구성되어 있기 때문에 model이 장기 정보를 활용할 수 있도록 한다.

- Transformer decoder layer는 총 12개이며 각 차원은 768차원이다. Self-Attention head는 각 64개의 Q,K,V와 12개의 head로 구성되어 있다.

- position-wise feed-forward는 총 3072차원이며 Adam optimizer(2.5e-4)를 사용했고, 100epoch동안 mini-batch size 64, 512 token으로 이루어진 연속적인 sequence를 무작위로 sampling하여 training을 진행했다.

supervised fine-tuning

λ를 0.5로 설정한 것을 제외하면 나머지 parameter는 unsupervised pre-training과 거의 동일하다.

실험 결과부터 말하자면, 본 논문의 접근법은 12개 dataset중 9개에서 SOTA를 달성하였다. 작은 dataset(STS-B, 약 5.7천개)부터 가장 큰 dataset(SNLI, 약 55만개)까지 다양한 크기의 dataset에서 잘 작동한다는 것을 보여준다.

Experiments result

- Natural Language Inference,NLI(자연어 추론): dataset으로 SNLI(이미지 캡션), 필기된 연설, MNLI(정부 보고서), QNLI(위키백과 기사), SciTail(과학 시험), RTE(뉴스 기사)를 포함하여 다양한 출처의 5가지 dataset에서 평가한다.

RTE를 제외한 4가지 dataset에서 SOTA를 달성했다. RTE는 평가한 dataset중에 가장 작은 크기이다.

RTE dataset의 경우 multi-task BilSTM model이 SOTA인데, 본 논문에서 제안한 model이 multi-task training으로부터 이점이 있을 것 같지만, 현재로써는 이를 아직 탐색하지 않았다고 한다.

- Question answering and commonsense reasoning(질문 응답 및 상식 추론): RACE dataset를 사용한다. 해당 dataset은 중,고등학교 시험에서 출처를 둔 영어 지문과 관련된 질문으로 구성되어 있다. CNN이나 SQuaD와 같은 다른 dataset보다 더 많은 추론 유형의 질문을 포함하고 있으며, 이는 장기 contexts를 처리하도록 training된 본 논문의 model에게 좋은 평가 기준을 제공한다.

Story Cloze Test는 두가지 선택지중 다중 문장 이야기의 올바른 결말을 선택하는 dataset이다.

모든 task에서 SOTA를 달성했다. 논문에서 제안한 model이 긴 범위의 contexts를 효과적으로 처리할 수 있음을 보여준다.

- Semantic Similarity(의미적 유사도): MRPC(Microsoft Paraphrase Corpus, 뉴스 출처), QQP(Quora Question Pairs), STS-B(텍스트 의미적 유사도 benchmark) dataset을 사용한다.

- Classification(분류): CoLA(Corpus of Linguistic Acceptability), SST-2(Stanford Sentiment Treebank, 표준 이진 분류 작업), GLUE benchmark를 통해 task를 평가한다.

거의 모든 task에서 SOTA를 달성했다.

5. Analysis

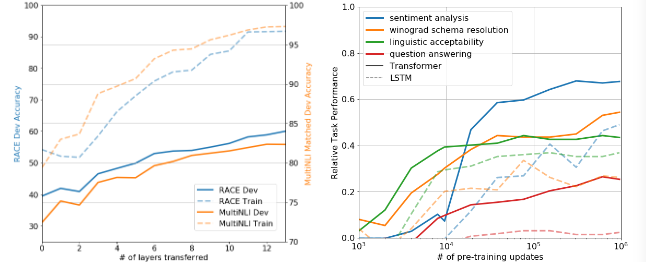

Impact of number of layers transferred - 층 전이의 영향

unsupervised pre-training에서 supervised task로 transfer된 layer의 영향을 관찰해본다.

- 왼쪽 그림은 MultiNLI와 RACE에서 전이된 layer의 수에 따른 성능이다. Embedding을 전이하면 성능이 향상된다는 것을 관찰했으며, pre-training된 model이 target task를 해결하는데 있어 유용한 기능을 포함하고 있을을 나타낸다.

Zero-shot Behaviors

왜 Language Model에서 pre-training된 Transformer가 효과적일까?

본 논문에서는 LSTM과 비교해서 Transformer의 Attnetional memory가 transfer에 도움이 된다고 가설을 세웠다.

- 오른쪽 그림에서 확인할 수 있듯이 대부분의 task에서 pre-training을 많이 진행할수록 Zero-shot 성능이 좋아지므로,

pre-training과정이 대부분의 Downstream task에 적합함을 알 수 있고, Transformer 구조가 LSTM보다 우월하다는 것을 알 수 있다.

Analysis of various model ablations on different tasks

다양한 model의 성능을 여러 task에서 비교해본다. 각 task의 성능 지표는 다음과 같다.

| Method | |

| CoLA(mathews correlation) | 문법적 수용 가능성 평가 |

| SST2(accuracy) | 감정 분석 |

| MRPC(F1 score) | 문장 paraphrase 검출 |

| STSB(Pearson correlation) | 의미 텍스트 유사성 평가 |

| QQP(F1 score) | Quora 질문 쌍 유사성 평가 |

| MNLI(accuracy) | 다국적 언어 불일치 |

| QNLI(accuracy) | 질문-응답 쌍 |

| RTE(accuracy) | 텍스트 추론 |

Ablation study

3가지 다른 조건의 제거 연구를 수행한다.

- auxiliary LM objective(보조 LM 목표) 없이 Fine-tuning된 Transformer

- single layer 2048 unit LSTM

- pre-training되지 않고 supervised target task에 직접 훈련된 Transformer

task 결과를 보면, auxiliary LM objective의 여부에 따라 각 task마다 순위가 갈리는데, large dataset에서는 auxiliary LM objective가 도움이 되고 small dataset에서는 도움이 되지 않는 모습을 볼 수 있다.

각 task의 성능 1등 공통점은 LSTM보다 pre-training된 Transformer가 우월하다는 점이라는 것을 보면 되겠다.

6. Conclusion

본 논문은 generative pre-training과 차별화된 Fine-tuning을 통해 다양한 task에 적용할 수 있는 model로 강력한 자연어 이해를 달성하기 위한 framework를 소개하였다.

제안한 model은 다양한 corpus의 긴 텍스트를 pre-training하며 전세계의 지식과 장기 의존성을 처리하는 능력을 습득하며, 12개의 dataset 중 9개 부분에서 SOTA를 달성했다.

Unsupervised (pre-)training을 성능 향상을 위해 사용하는 것은 오랫동안 machine learning의 연구 목표였다.

본 논문의 연구는 의미있는 성능 향상이 실제로 가능하다는 것을 제안하며 이후 나올 LLM model에게 새로운 연구 방향을 제시하였다.

7.Appendix

a. Auxiliary training objectives - 보조 학습 목표

model의 primary training objectives(주 학습 목표)를 보완하기 위해 추가적으로 설정하는 학습 목표이다. 주요 특징은 다음과 같다.

- 기본적인 Loss function에 추가적인 Loss로 포함되어 model이 여러가지 정보를 동시에 학습할 수 있도록 한다.

- 단일 목표를 학습하는 것보다 다양한 보조 목표를 추가하면, model의 overfitting을 방지할 수 있고 더 일반적인 패턴을 학습할 수 있다.

- 특정한 문제 도메인에서 유용한 추가적인 목표를 설정하여 더 유용한 표현을 학습할 수 있다.

- 예) BERT는 MLM과 NSP 두가지 보조 학습 목표를 함께 사용한다.

MLM(Masked Language Modeling), NSP(Next Sentence Prediction)을 통해 BERT는 contexts를 더 깊게 이해할 수 있다.

b. Zero-shot

Zero-shot learning(ZSL)은 model이 training과정에서 본 적 없는 새로운 클래스를 분할 수 있도록 하는 학습 방법이다.

즉, unseen data를 입력 받아도 training된 지식을 transfer하여 unseen data를 unseen class로 predict할 수 있다.

이를 위해서는 unseen class에 대한 설명 정보를 input으로 주어야 한다.

'강아지', '토끼', '고양이'의 classification model이 있다고 가정하자. '사자' class에 대해서는 training되지 않았지만,

input으로 '사자'라는 동물의 특징을 설명하는 text information을 넣는다면 model은 이를 활용하여 '사자'를 분류할 수 있다.

추가적으로, Generalized Zero-shot Learning(GZSL)이 있는데, ZSL과의 차이점은 다음과 같다.

- ZSL은 test시 unseen data만을 input으로 class를 predict

- GZSL은 test시 unseen, seen data를 모두 input으로 class를 predict

따라서 Real World 관점에서는 unseen, seen data를 input으로 받는 상황이 대부분이므로 GZSL이 더 적합하다고 볼 수 있다.